Настройка платы NVIDIA Jetson Nano

Подготовка платы очень похожа на то, что вы делаете с другими SBC, такими как Raspberry Pi, и у NVIDIA есть хорошее руководство по началу работы, поэтому мы не будем вдаваться в подробности. Обобщим:

- Загрузите последнюю версию прошивки (на момент написания обзора, это nv-jetson-nano-sd-card-image-r32.2.3.zip )

- Перепишите его с помощью balenaEtcher на карту MicroSD, поскольку в комплекте разработчика Jetson Nano нет встроенной памяти.

- Вставьте карту MicroSD в слот под модулем, подключите HDMI, клавиатуру и мышь, прежде чем, наконец, включить плату

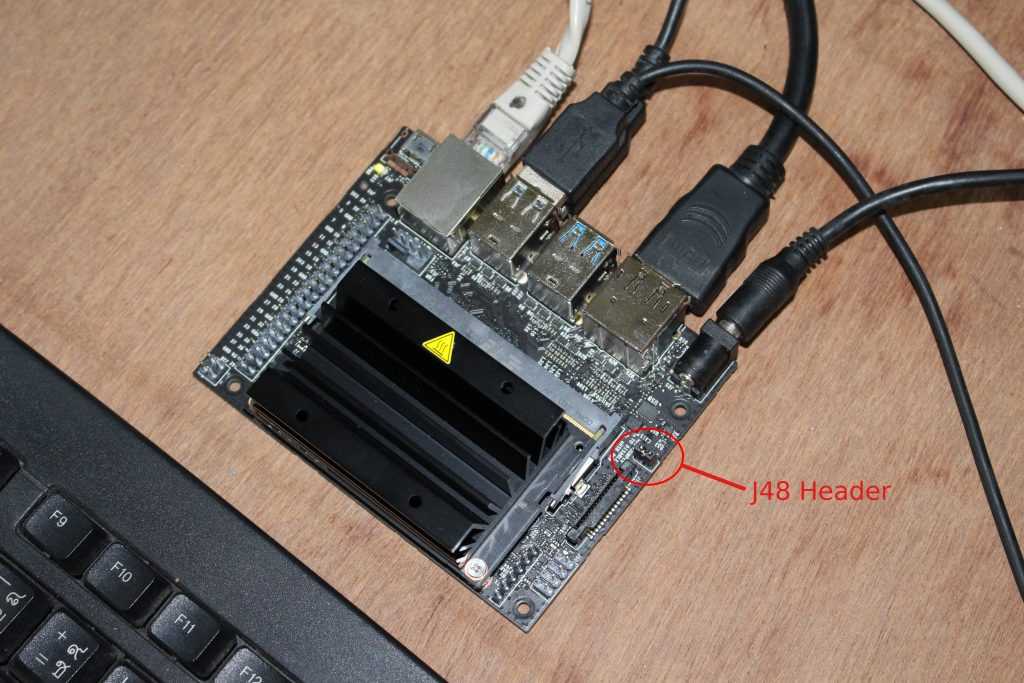

По умолчанию плата рассчитана на питание от источника 5 В через порт micro USB. Но, чтобы избежать возможных проблем с питанием, мы подключили источник питания 5 В/3 А к разъему постоянного тока и установили джампер на разъеме J48 для переключения источника питания.

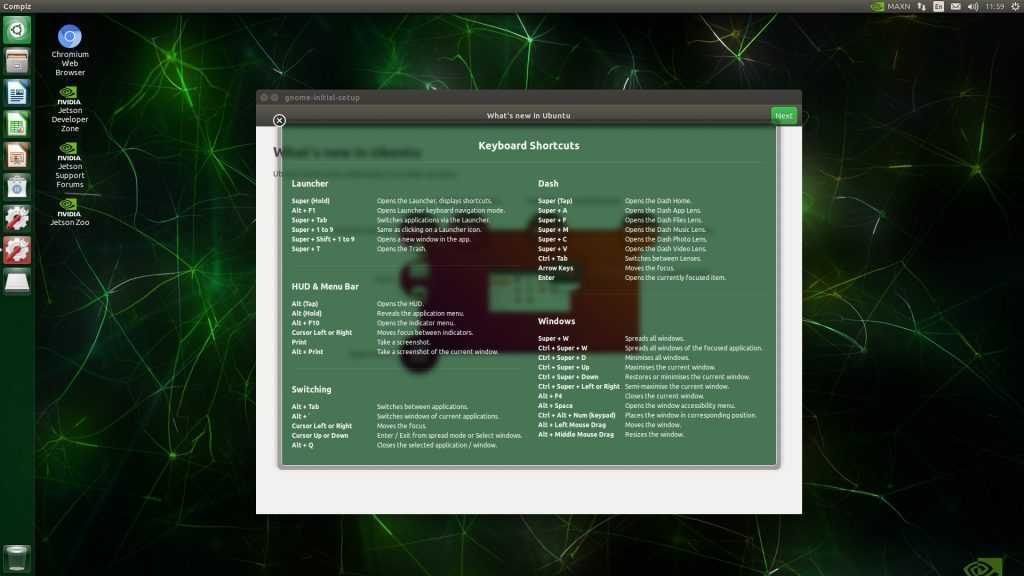

Плата быстро загрузилась в Ubuntu, и, после прохождения мастера настройки, чтобы принять пользовательское соглашение, выбрать язык, раскладку клавиатуры, часовой пояс и настроить пользователя, система выполнила некоторые настройки, и через пару минут мы были готовы идти.

Преимущества платформы NVIDIA для ИИ

Платформа NVIDIA покрывает все решения компании, от суперкомпьютеров для дата-центров до автономных устройств Jetson. Открытой платформой для разработки уже пользуется несколько сотен тысяч разработчиков: инструментарий для компактных Jetson мало отличается от того, что есть для привычных настольных GPU. Однако преимущество решений NVIDIA в том, что все они поддерживают CUDA и перенос кода или части вычислений с одного устройства на другое не вызовет никаких трудностей. Можно обучать модели в высокопроизводительных дата-центрах на Tesla, а внедрять их на компактных Jetson.

Миграция задачи с устройства на устройство происходит очень просто и бесшовно, поскольку базовая архитектура CUDA используется во всех продуктах компании, от Tesla/DGX для дата-центров до Jetson в компактных автономных устройствах. Все эти устройства различаются по производительности и функциональности, но с точки зрения программирования и удобства работы между ними разницы нет. И если у разработчика есть опыт работы с GPU, то он сможет заниматься и дата-центрами, и автономными устройствами.

Хотя NVIDIA традиционно считается компанией, производящей аппаратное обеспечение, она создает и программную часть. Специалисты компании разработали полноценный программный стек для автономных решений (рис. 4): в низкоуровневой его части лежит поддержка CUDA и Jetpack SDK для тех, кто хочет иметь прямой доступ к вычислениям, графическим ядрам, сенсорам и т. п., а за более высокий уровень отвечают модули, разработанные как самой компанией, так и ее партнерами. Эти модули помогают решать задачи тем, кто не хочет или не может заниматься низкоуровневым программированием, — им доступны такие аппаратно-ускоренные возможности, как определение глубины сцены, распознавание объектов, поз и жестов, планирование траекторий, распознавание голосового ввода и др.

Рис. 4. Единый программный стек для решений на базе модулей NVIDIA Jetson

NVIDIA поощряет разработку сторонних модулей, не имеющих к компании никакого отношения. В качестве примера можно привести компанию Fastvideo, известную обработкой изображений. Они работают с низкоуровневым слоем экосистемы NVIDIA, а сторонние компании могут использовать готовые библиотеки их разработки, оптимизированные для аппаратной части NVIDIA.

Среди ПО NVIDIA существует также Deepstream SDK — часть программной платформы для анализа данных с камер и сенсоров в реальном времени, использующая аппаратное ускорение. SDK создан не только для Jetson, но и для других решений NVIDIA: он позволяет реализовать рабочий процесс, связанный с видеоаналитикой, — захват изображения, распознавание образов, накопление и хранение видео и т. д. Программная инфраструктура постоянно развивается, и за последние три года поддерживаемая Jetpack версия CUDA изменилась с 7.0 до 10, TensorRT — с 1.0 до 5.0, Deepstream — до 3.0, а Ubuntu — с 14.04 до 18.04. В более новом ПО не только исправляют ошибки и улучшают производительность, но и добавляют новую функциональность.

В этом заключается основное преимущество линейки NVIDIA Jetson — они позволяют создавать программно определяемые системы, использующие модели глубокого обучения с аппаратным ускорением. Специалисты NVIDIA считают, что все устройства должны быть не узкоспециализированными, а настраиваемыми — чтобы изменением лишь программной части можно было дополнить и улучшить функциональность устройства в целом. При этом разработчики могут ориентироваться на разный бюджет: если Xavier потребуется для решения самых сложных задач, то тот же Nano позволит недорого получить производительность, вполне достаточную для анализа нескольких видеопотоков одновременно. Все эти устройства используют одно и то же ПО, и только за счет смены аппаратного решения можно получить прирост производительности и расширение возможностей, без необходимости переделывать программный код.

Миниатюрные ИИ-компьютеры

Jetson Nano – не единственный компактный компьютер с поддержкой искусственного интеллекта, хотя подобных продуктов на рынке пока не так много. На стороне детища Nvidia – невысокая стоимость. Для сравнения, вышедший в июле 2017 г. ИИ-компьютер Intel Neural Compute Stick, выполненный в виде USB-флешки, стоит $79 (5,1 тыс. руб.), но имеет существенно меньшую производительность – в пределах 100 гигафлопс.

Схожие продукты есть и у Google – интернет-гигант распространяет их под своим брендом Coral. Так, USB-стик под названием USB Accelerator стоит $75, обладает размерами 65х30 мм и стоит $75 (4,8 тыс. руб.), а за $150 (9,7 тыс. руб.) Google предлагает плату для разработчиков Coral DevBoard с 4-ядерным процессором, 1 ГБ оперативной памяти и флеш-накопителем 8 ГБ. К преимуществам данного решения можно отнести лишь штатные модули Bluetooth 4.1 и двухдиапазонный (2,4 ГГц и 5 ГГц) модуль Wi-Fi 802.11ac, по умолчанию не предусмотренные в Nvidia Jetson Nano, а также активное охлаждение центрального процессора.

Coral DevBoard

Coral DevBoard

- Короткая ссылка

- Распечатать

Hardware

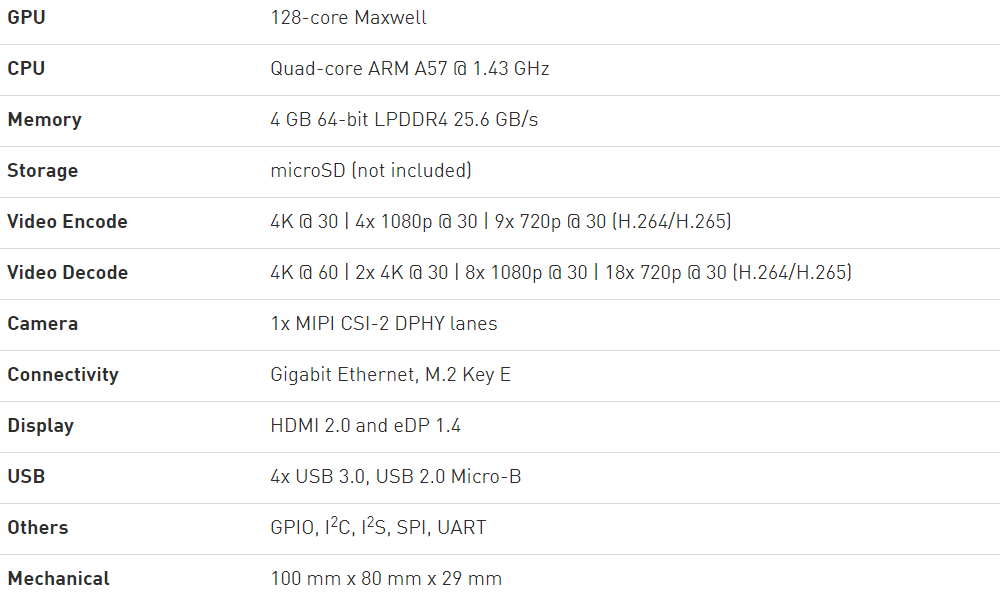

Для начала, технические характеристики с сайта NVIDIA:

Из интересного, здесь можно отметить несколько моментов.

Первое — это GPU, имеющий 128 ядер, соответственно, на плате можно запускать GPU-ориентированные задачи, вроде CUDA (поддерживается и установлен из «коробки») или Tensorflow. Основной процессор 4х ядерный, и как будет показано ниже, вполне неплохой. Память 4Гб, общая между CPU и GPU.

Второе — это совместимость с Raspberry Pi. Плата имеет 40-пиновый разъем с различными интерфейсами (I2C, SPI и пр), также имеется разъем камеры, который тоже совместим с Raspberry Pi. Можно предположить, что большое количество уже имеющихся аксессуаров (экраны, платы управления моторами и пр) будут работать (возможно придется использовать удлиннительный кабель, т.к. Jetson Nano по размеру больше чем Raspberry Pi).

Третье — на плате имеется 2 HDMI-выхода, Gigabit-Ethernet и USB 3.0, т.е. Jetson Nano в целом даже чуть более функциональна чем «прообраз». Питание 5В, может браться как по Micro USB, так и через отдельный разъем, который рекомендуется для майнинга биткоинов ресурсоемких задач. Так же как и в Raspberry Pi, софт грузится с SD-карты, образ которой нужно предварительно записать. В целом, по идеологии, плата вполне похоже на Raspberry Pi, что видимо и задумывалось в NVIDIA. Но вот WiFi на плате нет, что есть определенный минус, желающим придется использовать USB-WiFi модуль.

Кстати о цене. Оригинальная цена Jetson Nano в США 99$, цена в Европе с наценкой в местных магазинах порядка 130Евро (если ловить скидки, наверно можно найти и дешевле). Сколько стоит Nano в России, неизвестно.

Сколько стоит Jetson Nano?

Цена – это еще один аспект, который мы еще не рассмотрели. Цена платы Google Coral Dev составляет 149,99 долларов, а Jetson Nano – всего 99 долларов. Если доска Coral Dev не принесет чего-то уникального, любители и мелкие разработчики могут найти дополнительные 50 долларов, которые трудно оправдать.

В настоящее время цены на SOM для любой платы отсутствуют, но я думаю, что для большинства разработчиков хобби это не так важно. С коммерческой точки зрения, разница между производительностью и ценой будет иметь решающее значение для Jetson Nano и платы Coral Dev

Jetson Nano можно приобрести у Nvidia напрямую у сторонних продавцов.

купить: Джетсон Нано прямой от Nvidia

⇡#Компьютерные игры как средство развития когнитивных способностей

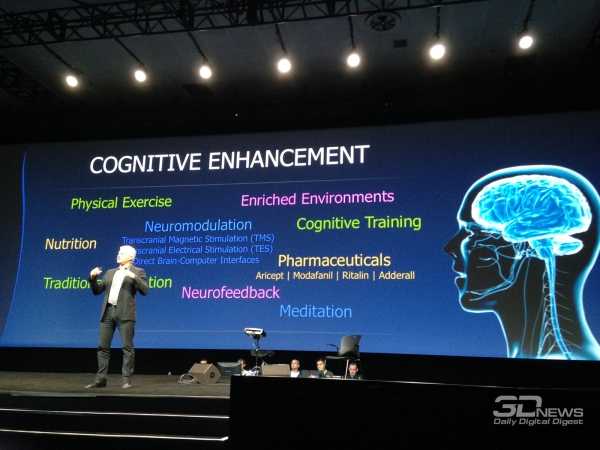

В одной из основных презентаций GTC была представлена перспективная инициатива — повысить когнитивные способности людей и поддержать последние в период старения при помощи задач, сходных с компьютерными играми, или даже полноценных игр, сконструированных на базе научной модели.

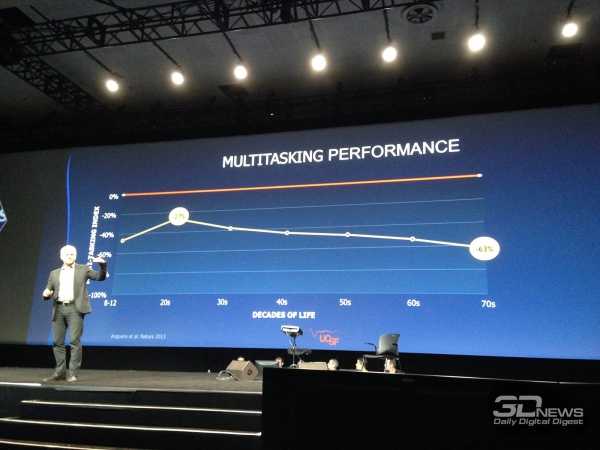

Известно, что с возрастом когнитивные способности человека неуклонно снижаются. К примеру, одновременное выполнение нескольких задач, требующих концентрации внимания, у 20-летних испытуемых вызывает на 27% больше ошибок, чем при выполнении одной задачи, а на восьмом десятке разница достигает уже 63%.

Существует множество способов в той или иной степени компенсировать угасание когнитивных способностей, из которых чаще всего применяется фармакологическая терапия. Но этот метод имеет ряд существенных издержек: неточное определение источника проблем, недостаточный учет индивидуальных особенностей пациента, длительный цикл «воздействие — оценка результатов».

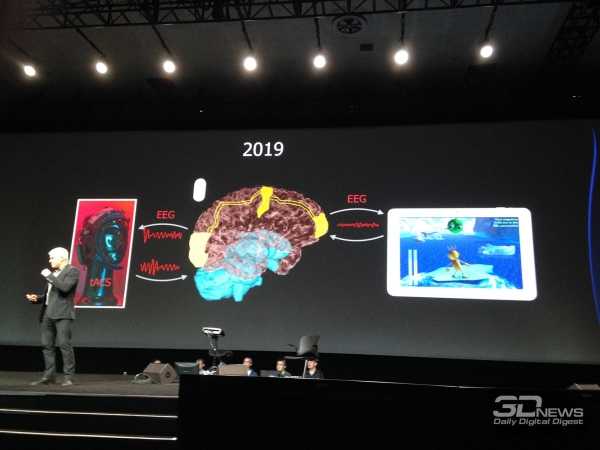

Аналогичная игра Neuro Drummer построена на идее связи когнитивных способностей и ритмической активности. На сцену вышел перкуссионист Микки Харт (Mickey Hart), известный своей работой в группе Grateful Dead, чтобы продемонстрировать следующий опыт. На испытуемом были надеты очки виртуальной реальности Oculus Rift и шапка для регистрации ЭЭГ. Под музыкальную «минусовку» Микки играл на виртуальной ударной установке, тем самым управляя событиями в игровой среде. Зрители наблюдали за тем, что происходит в очках Микки. Одновременно на экран выводилась визуализация активности мозга, выполненная программой Glass Brain. Анализ данных ЭЭГ в реальном времени выполнялся на GPU NVIDIA. В будущих версиях Neuro Drummer появятся более разнообразные когнитивные задачи — запоминание, классификация и так далее.

Для чего он будет использоваться?

Учитывая его мастерство в области видеоанализа и малый форм-фактор, Jetson Nano почти наверняка проявит себя в робототехнике и автономных транспортных средствах. Многие из демонстраций показывают эти приложения в действии.

Учитывая его мощность и размер, он также, вероятно, будет работать во встроенных системах, которые полагаются на распознавание лиц и объектов.

Для любителей, как мы? Кажется, это идеальное сочетание мощных возможностей машинного обучения с фактором, знакомым любому, кто возился с Raspberry Pi. В то время как вы можете использовать рамки машинного обучения, такие как TensorFlow на Raspberry Pi

Начните с распознавания изображений с помощью TensorFlow и Raspberry Pi

Начните с распознавания изображений с помощью TensorFlow и Raspberry PiХотите справиться с распознаванием изображений? Благодаря Tensorflow и Raspberry Pi, вы можете начать прямо сейчас.

Прочитайте больше

, Jetson Nano гораздо больше подходит для этой задачи.

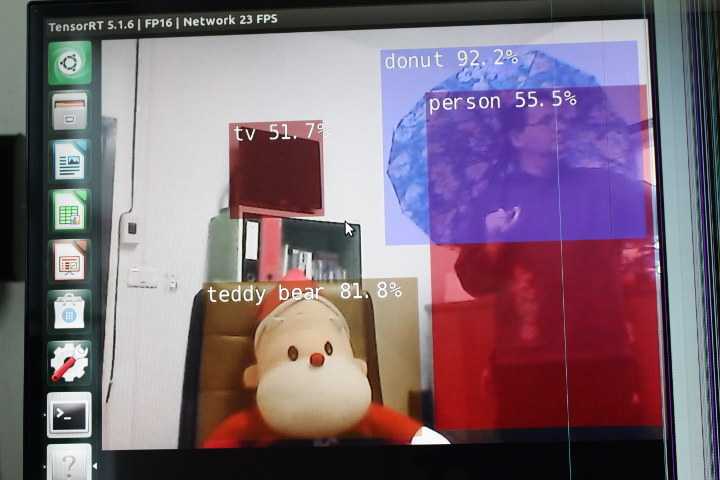

Обнаружение объектов из потока RTSP

Теоретически, мы могли бы зациклить образец Tiny Yolov3 для стресс-тестирования, но чтобы постоянно нагружать GPU, лучше всего сделать вывод на видеопотоке. Часть образца Detenet-Camera из Jetson Inference (известная как AI Hello World) может выполнять эту работу, если у вас есть совместимая USB-камера.

У нас есть две старые веб-камеры, которые мы купили 10-15 лет назад. Нам никогда не удавалось заставить Logitech Quickcam работать в Linux или Android, но раньше мы могли использовать меньшую камеру «Venus 2.0» в обеих операционных системах. На этот раз нам так и не удалось заставить последнюю работать ни в Jetson Nano, ни в ноутбуке Ubuntu 18.04. Если вы хотите получить камеру MIPI или USB, которая наверняка работает с платой, ознакомьтесь со

Но, потом мы подумали … эй, у нас есть одна камера, которая работает! Веб-камера на ноутбуке. Конечно, мы не можем просто подключить его к плате NVIDIA, и, вместо этого, мы запустили поток H.264 с помощью VLC:

cvlc — это утилита командной строки для VLC. Мы также могли воспроизводить поток на ноутбуке:

У нас было отставание около 4 секунд, и мы подумали, что установка опции сетевого кэширования на 200 мс может помочь, но вместо этого, видео было кускамиТак что проблема в другом, и у нас не было времени заняться этим.Важной частью является то, что нам удалось заставить поток работать:

Когда мы пытались воспроизвести поток в Jetson Nano с помощью VLC, всплыла ошибка сегментации. Но, давайте не будем зацикливаться на этом, а посмотрим, сможем ли мы сделать detectnet-camera для работы с нашим потоком RTSP.

Кто-то это несколько месяцев назад, так что это очень помогло. Нам нужно отредактировать исходный код ~ / jetson-inference / build / utils / camera / gstCamera.cpp в двух частях файла:

- Отключите обнаружение камеры CSI в gstCamera::ConvertRGBA:

2. Жестко запрограммируйте поток RTSP в gstCamera:: buildLaunchStr:

Теперь мы можем восстановить образец и запустить программу:

и успех! При условии, что мы держим на голове массивный пончик, а Санта-Клаус — плюшевый мишка…

Консоль постоянно обновляется с обнаруженными объектами и отчетом о времени.

Этот пример — хороший способ начать подключать одну или несколько IP-камер к Jetson Nano, чтобы использовать AI для снижения ложных предупреждений вместо примитивного PIR-обнаружения, часто используемого в камерах наблюдения. Мы поговорим подробнее об использовании процессора и графического процессора, а также о тепловых нагрузках в следующем посте.

Нам хотелось бы поблагодарить Seeed Studio за отправку нам комплекта разработчика NVIDIA Jetson Nano для оценки. Комплект

Выражаем свою благодарность источнику из которого взята и переведена статья, сайту cnx-software.com.

Оригинал статьи вы можете прочитать здесь.

Обман раскрылся

Инвесторы Nvidia обвинили компанию в предоставлении неверных сведений о продажах видеокарт на базе ее процессоров в период бума криптовалют. В ответ на дезинформацию инвесторы подали на нее в суд.

Речь идет о 2017 г., когда курсы криптовалют, в особенности биткоина, демонстрировали стремительный рост, что и привлекало желающих заработать на этом. К примеру, в декабре 2017 г. стоимость биткоина достигла отметки $20 тыс. – это стало рекордно высоким показателем за всю историю данного токена.

Как пишет ресурс WCCFTech, суть спора заключается в том, что после спада интереса к криптовалюте и последовавшем за ним снижении продаж видеокарт Nvidia указала неверные данные о размере прибыли с карт, реализованных майнерам. Также она не сообщила истинные сведения о том, как сильно на тот период времени ее финансовые показатели зависели от людей, стремящихся обогатиться за счет добычи криптовалюты и скупающих для этого видеокарты.

В качестве доказательств обвинений в иске приведены показания пяти экс-сотрудников Nvidia. В их число вошли старший менеджер по работе с клиентами в китайском представительстве компании, старший директор по продуктам из офиса в Калифорнии, старший директор по потребительскому маркетингу в представительстве Nvidia Латинской Америке, а также комьюнити-менеджер из московского офиса (у Nvidia два офиса в России – в Москве и Нижнем Новгороде).

Против Nvidia ополчились все ее инвесторы

Против Nvidia ополчились все ее инвесторы

Эти четыре человека ушли из компании не позднее 2017 г. Пятым свидетелем, на чьи показания опираются инвесторы Nvidia – это глава отдела потребительского маркетинга Nvidia в Южной Азии, который занимал эту должность до 2019 г. Имена этих людей не раскрываются, и на вопросы CNews о бывшем российском сотруднике Nvidia представители компании на момент публикации материала ответить не смогли.

Nvidia – это один из двух крупнейших производителей графических процессоров для видеокарт. Ее основной и единственный конкурент – компания AMD, занимающаяся производством GPU с момента покупки компании Ati в 2006 г. За I квартал финансового 2021 года, закончившегося для Nvidia 27 апреля 2020 г., ее выручка составила $3,08 млрд. В сравнении с аналогичным периодом финансового 2020 года этот показатель вырос на 39%.

⇡#Iray VCA

Iray VCA (Visual Computing Appliance) — сетевая рабочая станция в формате 19-дюймовой стойки, предназначенная для ускорения трассировки лучей в рендерере NVIDIA Iray. Iray используется в таких приложениях, как CATIA от Dassault Systemes и 3ds Max от Autodesk.

В состав VCA входят восемь полностью функциональных процессоров GK110 (2880 ядер CUDA в каждом). С помощью интерфейса InfiniBand несколько Iray VCA можно объединить в кластер.

С точки зрения железа Iray VCA сопоставим с другим продуктом NVIDIA — GRID VCA. Разница в том, что GRID VCA выполняет функции виртуализации GPU в формате «один GPU — один пользователь». Напротив, Iray VCA объединяет вычислительные возможности нескольких GPU в рамках одной задачи. Его основное назначение — рендеринг фотореалистичных изображений методом трассировки лучей (Ray Tracing). Ray Tracing используется не только в графическом дизайне, но и в промышленности. К примеру, производители автомобилей таким образом создают физически достоверные модели машин, с помощью которых можно исследовать некоторые параметры проекта без необходимости производить материальный прототип.

Речь идет не о статичных изображениях или предварительно отрендеренных видеороликах, а о манипуляции моделью в реальном времени, как это происходит в компьютерных играх. Правда, в отличие от игр, в силу чрезвычайно высокой ресурсоемкости метода Ray Tracing, для этой задачи требуется одновременно нескольких десятков GPU.

Honda первой построила кластер из 25 Iray VCA, который позволяет выполнять трассировку лучей в реальном времени для моделирования автомобилей — как внешнего дизайна, так и всех деталей, которые находятся внутри.

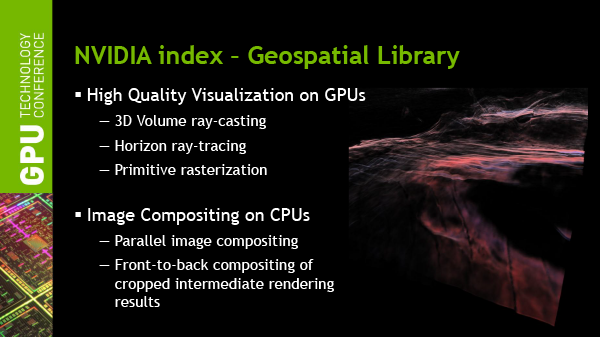

Предварительная розничная цена Iray VCA на рынке США составляет $50 000. Вместе с оборудованием клиент получает лицензию на NVIDIA Iray, а также ПО Iray VCA Cluster Manager. VCA также найдет применение для анализа больших объемов геологических данных при помощи ПО NVIDIA IndeX.

Достоинства Ray Tracing по сравнению с растеризацией — методом рендеринга, используемым в играх, — были наглядно показаны в презентации Pixar, которая также участвовала в GTC. Посмотрите на список локальных источников света, которые дизайнер был вынужден расставлять вручную, чтобы получить аппроксимацию реалистичного освещения без применения Ray Tracing.

Трассировка лучей позволяет обойтись несколькими «физическими» источниками, распространение света от которых симулируется с учетом отражения от поверхностей всех предметов в кадре.

Рендеринг методом Ray Tracing имеет особенность: сначала формируется очень шумная картинка, которая проясняется с течением времени. Это не проблема для Pixar, поскольку видео записывается «в офлайне», но для создания моделей автомобилей, которыми можно манипулировать в реальном времени, требуются именно такие мощности, какими обладает кластер NVIDIA Iray VCA.

⇡#Подробности о DirectX 12

После консультации с сотрудниками NVIDIA мы подготовили дополнение к предварительному обзору грядущего API от Microsoft, который мы сделали ранее по горячим следам.

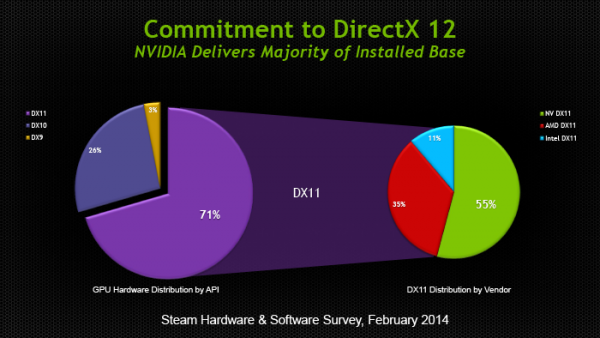

Прежде всего, стало известно, что спецификации API уже финализированы в достаточной степени, чтобы два из трех ведущих производителей GPU (NVIDIA и Intel) выпустили драйвер под DirectX 12 для закрытого использования. Таким образом, разработчики приложений могут заранее приступить к внедрению DX12. Напомним, что Mircosoft пообещала появление первых игр с поддержкой DX12 в конце 2015 года. AMD пока задерживается с драйвером для собственных GPU.

Мы получили ответ на вопрос, почему DirectX 12 часто описывают как более низкоуровневый API по сравнению с DirectX 11. Runtime-библиотека Direct3D больше не выполняет некоторые функции управления ресурсами, свойственные ей в предыдущей версии. Теперь приложение само должно следить за тем, по каким адресам в памяти расположены ресурcы. С одной стороны, эта модель более эффективна, поскольку приложение «знает», как и для чего используются ресурсы. Runtime-библиотека в модели Direct3D 11 вынуждена предсказывать такие вещи на основании поступающих от приложения вызовов. В DX12 разработчики игровых движков получат возможность лучше дифференцировать свои продукты. С другой стороны, писать код под DirectX 12 для неопытных разработчиков станет сложнее.

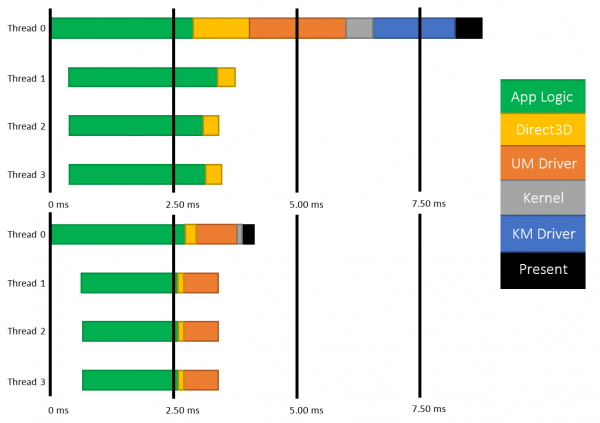

Есть уточняющий комментарий к диаграмме распределения нагрузки между потоками CPU в 3DMark, который ранее был опубликован в блоге на MSDN. В разделе DirectX 12 из диаграмм пропал компонент драйвера, исполняемый в Kernel Mode. На самом деле он никуда не делся, просто, по всей видимости, его исключили для простоты представления, или же этот компонент стал настолько «тонким», что неразличим в использованном масштабе.

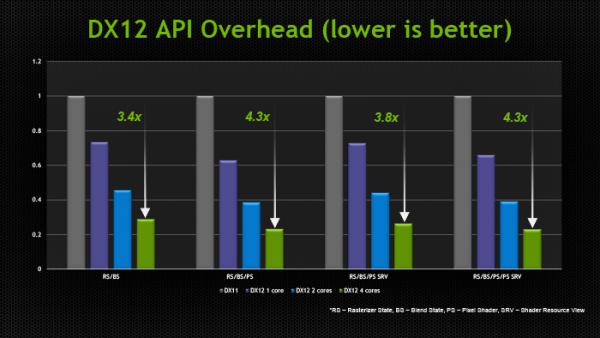

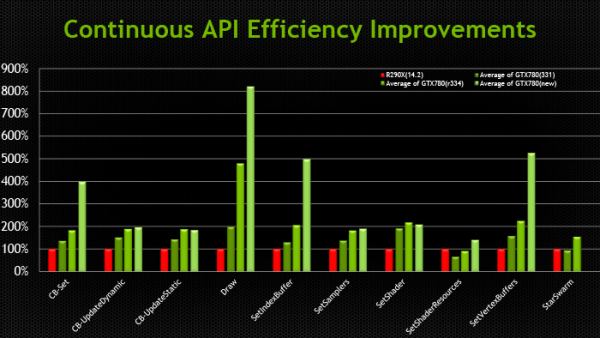

Кроме того, у NVIDIA есть результаты измерений, которые напрямую отражают снижение расхода производительности (overhead) при смене состояний конвейера Direct3D, что является одним из главных достоинств DirectX 12. В наиболее благоприятном случае достигается разница в 3,8-4,3 раза.

Наконец, стоит прокомментировать, что подразумевается под совместимостью с DirectX 12 существующих графических процессоров, поддерживающих DirectX 11. Номер DirectX, с одной стороны, указывает на версию runtime-библиотеки, в которой-то и произошли самые большие изменения на этот раз. С другой стороны, есть feature level, который определяет набор функций, доступных GPU. К примеру, библиотекой Direct3D 11.2 поддерживаются feature levels от 9_1 до 11_1, которые соответствуют графическим процессорам, выпущенным в разное время «под DirectX 9, 10 и 11». Точно так же все это оборудование будет использоваться и библиотекой Direct3D 12.

В то же время Direct3D 12 принесет новый feature level. Полный список нововведений пока не разглашается, но известны три из них. Pixel Shader Ordering представляет собой механизм контроля за доступом пиксельного шейдера к ресурсам в определенном порядке, что предотвращает появление артефактов при отрисовке прозрачных объектов. Это подобие расширения PixelSync, которое Intel ранее ввела для GPU Iris.

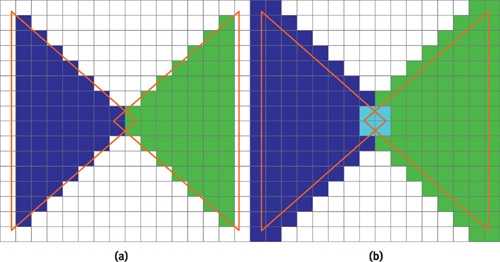

Еще одна аппаратная функция — Conservative Rasterization — обеспечивает более эффективное отсечение невидимых поверхностей на ранних стадиях рендеринга.

а) стандартная растеризация, б) консервативная растеризация

Список закрывает поддержка новых форматов сжатых ресурсов — ASTC (ранее представлен ARM, поддерживается официальным расширением OpenGL) и JPEG.

Ну а пока еще не существует коммерческих продуктов на основе DirectX 12, NVIDIA работает над оптимизацией драйвера GPU под DirectX 11. В одном из следующих релизов существенно сокращен overhead при смене состояний конвейера, что отражается на производительности в задачах, интенсивно нагружающих CPU.

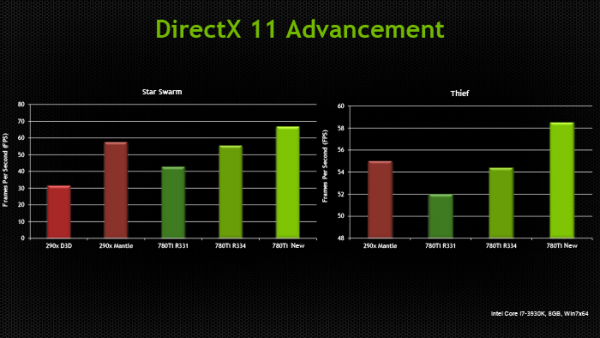

В бенчмарке Star Swarm, чрезвычайно тяжелом для CPU за счет генерации фантастического количества draw calls, GeForce GTX 780 Ti под DirectX 11 оставляет позади Radeon R9 290X, работающий под Mantle. Кроме того, поскольку Star Swarm настолько завязан на производительность CPU, бонус, который Radeon R9 290X получает от Mantle, и отставание от GTX 780 Ti в режиме DirectX 11, указывает на серьезные недостатки существующего драйвера AMD под DX11.

Может ли он заменить мой Raspberry Pi?

Несмотря на то, что плата Google Coral Dev мощная, в некоторых отношениях она не складывается с Raspberry Pi. Raspberry Pi – отличный компьютер для любителей электроники. Это может также удваиваться как настольный компьютер

Использование Raspberry Pi в качестве настольного ПК: 7 вещей, которые я выучил через неделю

Использование Raspberry Pi в качестве настольного ПК: 7 вещей, которые я выучил через неделюМожет ли скромный Raspberry Pi заменить настольный ПК? Я потратил семь дней на написание и редактирование Pi, с интересными результатами.

Прочитайте больше

в крайнем случае.

Конечно, плата Coral Dev является мощной, но их собственные документы рекомендуют не подключать мышь и клавиатуру. Пользовательская ОС Coral предназначена в первую очередь для SSH-соединений. Однако он, вероятно, способен выдержать любой вариант Linux. Это ставит его прямо как прямой конкурент Pi

Есть проблема, хотя. Если вам нужна доска для обучения машинному обучению, но которая может выполнять и другие повседневные задачи, зачем вам покупать Coral Dev Board?

Jetson Nano поддерживает порт дисплея, и, как уже упоминалось ранее, имеет впечатляющие примеры видео прямо из коробки. Настраиваемый рабочий стол Ubuntu будет знаком многим, а более дешевая цена сделает его привлекательной перспективой для многих, даже тех, кто не заинтересован в машинном обучении.

⇡#Jetson TK1

Третий из крупных анонсов GTC — платформа для разработчиков Jetson TK1 на базе SoC Tegra K1. Цель NVIDIA — подстегнуть разработку встраиваемых систем, использующих GPU для параллельных вычислений, включая те задачи, в которых ранее использовались чипы FPGA, ASIC и DSP.

GPU в составе чипа обладает архитектурой Kepler и содержит 192 ядра CUDA. Таким образом, Jetson TK1 является идейным наследником предыдущего комплекта для разработчиков под названием Kayla, который был представлен на прошлогодней GTC и представлял собой двухчиповое решение на базе Tegra 3 и дискретного GPU GK208. К слову, в следующей итерации платформы Tegra — Erista — будет использоваться GPU на архитектуре Maxwell.

На плате Jetson TK1 распаяно 2 Гбайт RAM, 16 Гбайт flash-памяти, слот для SD-карт и порт SATA. Для коммуникации с внешними устройствами предусмотрены разъемы USB 3.0, HDMI 1.4, Gigabit Ethernet и COM-порт. На SoC нет предустановленного кулера, но благодаря тому, что энергопотребление Tegra K1 не превышает 10 Вт, разработчики могут решить эту задачу самостоятельно.

Jetson поддерживает полный набор инструментов программирования под API CUDA 6.0. Платформа работает под управлением 32-битной версии Ubuntu 13.04 для архитектуры Tegra. Кроме того, NVIDIA портировала на ARM-библиотеки VisionWorks, которые содержат алгоритмы так называемого машинного зрения — оно применяется в робототехнике, автомобильных компьютерах, системах дополненной реальности и так далее.

Помимо платы Jetson, представленной на GTC, NVIDIA выпустила аналогичный комплект Jetson Pro, предназначенный специально для установки в автомобили. В отличие от Jetson TK1, Jetson Pro комплектуется относительно старым SoC Tegra 3, но обладает слотом PCI-E для опциональной установки дискретного GPU.

В ходе GTC были продемонстрированы примеры практического применения Tegra K1 во встраиваемых компьютерах. NVIDIA переделала приборные панели нескольких авто, полностью заменив механические органы управления бортовыми системами огромным сенсорным дисплеем. Отдельный экран занимает место приборной панели.

К слову, электрокар Tesla Model S в штатной поставке оснащается бортовым компьютером на базе Tegra с 17-дюймовым экраном.

Но CUDA во встраиваемых решениях имеет и более интересные применения, нежели рендеринг пользовательского интерфейса. На GTC мы увидели модифицированную Audi, которая обладает возможностями автопилота. С помощью библиотек VisionWorks на Tegra K1 реализуются функции машинного зрения для помощи человеку в процессе вождения. Бортовой компьютер находит свободное место для парковки в ряду машин, может отслеживать разделительные полосы на дороге. Камера, обращенная внутрь салона, наблюдает за тем, не уснул ли водитель за рулем.

Какие выставки перенесли или отменили

С 16 по 20 марта в Сан-Франциско должна была пройти Game Developers Conference — крупнейший слёт разработчиков игр. В прошлом году, например, студия Paradox анонсировала на ней Vampire: The Masquerade — Bloodlines 2, а представила облачный сервис Stadia. В этом же году эпидемия вынудила крупные компании отложить визит на мероприятие. 26 февраля в Сан-Франциско ввели чрезвычайное положение для профилактики заболевания и это веская причина отказаться от посещения конференции. Среди компаний, которые предпочли не рисковать здоровьем своих сотрудников, Electronic Arts, Kojima Productions, Sony, Microsoft, Blizzard и Activision. Как итог — выставку перенесли на лето, когда ситуация с вирусом, по прогнозам врачей, должна поутихнуть.

Это Сан-Франциско, город в зоне риска

Без потерь не обошлась и другая крупная выставка — PAX East 2020. Туда отказались приезжать PUBG Corp, Square Enix, Capcom, CD Project RED и, опять же, Sony. Последних даже лично упрашивал приехать мэр Бостона, мол, не бойтесь, у нас все под контролем. Но компания не поддалась на уговоры, а значит, мы снова остались без анонсов: Sony обещала показать на выставке много нового. Среди заявленного были демоверсии Nioh 2, Final Fantasy VII Remake и долгожданная The Last of Us Part II. Если вы ждали подробностей о Cyberpunk 2077, то не расстраивайтесь: по словам CD Projekt RED, студия всё равно не собиралась ничего рассказывать.

Пополнила список «коронованных» мероприятий и GTC — GPU Technology Conference, которая должна была пройти 22-26 марта. На GTC посетители узнавали последние новости в сфере графических процессоров, машинного обучения и искусственного интеллекта. В этом году мероприятие планировали посетить почти 10 000 человек. Увы, Nvidia решила перенести конференцию в онлайн-пространство и вернуть деньги всем, кто купил билеты. Полноформатного ивента с живыми презентациями не будет: участникам предложили опубликовать свои выступления на сайте мероприятия.

Тысячи людей остались без праздника

Что оно может делать?

Никого не удивит, что Nvidia разработала доску, хорошо подходящую для визуальных задач. Распознавание объектов является ключевым моментом здесь, и Visionworks SDK имеет много потенциальных приложений в этой области.

Вместо того, чтобы использовать отдельный процессор для задач машинного обучения, Jetson Nano использует графический процессор Maxwell с 128 ядрами CUDA для тяжелой работы.

В проекте Jetson Inference представлены демонстрации предварительно обученной нейронной сети, обеспечивающей высокопроизводительное распознавание нескольких объектов в различных средах. Отслеживание функций, стабилизация изображения, прогнозирование движения и одновременная обработка нескольких источников – все это доступно в доступных демонстрационных пакетах.

Возможно, наиболее впечатляющим является технология DeepStream, показанная в приведенном выше видео. Выполнение аналитики в режиме реального времени на восьми одновременных потоках 1080p со скоростью 30 кадров в секунду на небольшом одноплатном компьютере невероятно и показывает потенциальную мощь оборудования Nano.